【经典卷积神经网络】之AlexNet分析及实现牛津花卉数据集分类

【经典卷积神经网络】之AlexNet分析及实现牛津花卉数据集分类

一、内容

2012年,深度学习三巨头之一、具有神经网络之父之称的 Geoffrey Hinton 的学生 Alex Krizhevsky 率先提出了 AlexNet,并在当年度的 ILSVRC(ImageNet大规模视觉挑战赛)以显著的优势获得当届冠军,top-5 的错误率降至了 16.4%,相比于第二名 26.2% 的错误率有了极大的提升。

论文地址:

https://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks.pdf

AlexNet 的创新点在于:

1)首次成功使用 relu 作为激活函数,使其在较深的网络上效果超过传统的 sigmoid 激活函数,极大的缓解了梯度消失问题。

2)首次在实践中发挥了 dropout 的作用,为全连接层添加 dropout 防止过拟合。

3)相较于之前 Le-Net5 中采用的平均池化,AlexNet 首次采用了重叠的最大池化,避免了平均池化的模糊化效果。

4)提出了 LRN 层,对局部神经元的活动创建了竞争机制。

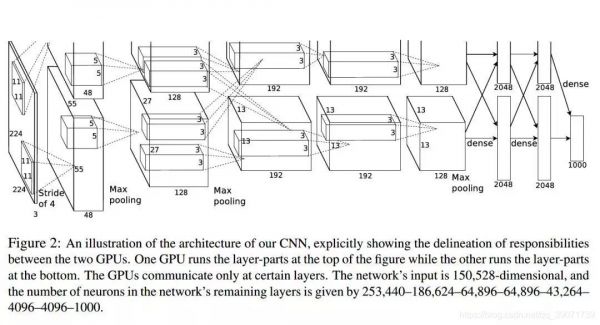

5)使用多 GPU 进行并行计算。采用了一定的数据增强手段,一定程度上也缓解了过拟合。

AlexNet 不算池化层总共有 8 层,前 5 层为卷积层,其中第一、第二和第五层卷积都包含了一个最大池化层,后三层为全连接层。所以 AlexNet 的简略结构如下:

输入>卷积>池化>卷积>池化>卷积>卷积>卷积>池化>全连接>全连接>全连接>输出各层的结构和参数如下:

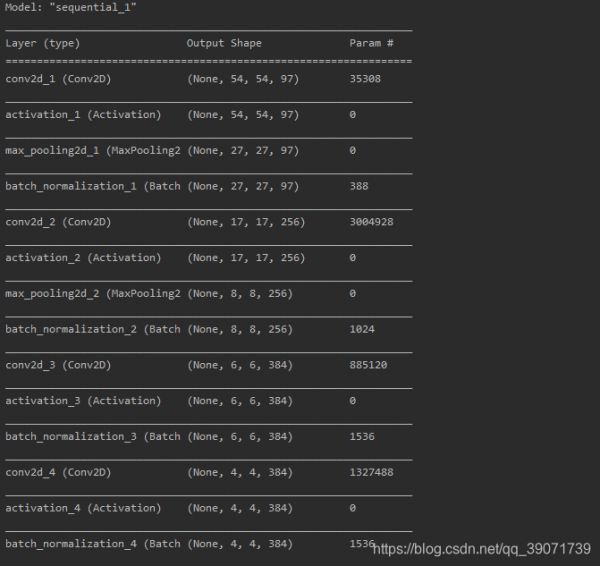

C1层是个卷积层,其输入输出结构如下:

输入: 227 x 227 x 3 滤波器大小: 11 x 11 x 3 滤波器个数:96

输出: 55 x 55 x 96

P1层是C1后面的池化层,其输入输出结构如下:

输入: 55 x 55 x 96 滤波器大小: 3 x 3 滤波器个数:96

输出: 27 x 27 x 96

C2层是个卷积层,其输入输出结构如下:

输入: 27 x 27 x 96 滤波器大小: 5 x 5 x 96 滤波器个数:256

输出: 27 x 27 x 256

P2层是C2后面的池化层,其输入输出结构如下:

输入: 27 x 27 x 256 滤波器大小: 3 x 3 滤波器个数:256

输出: 13 x 13 x 256

C3层是个卷积层,其输入输出结构如下:

输入: 13 x 13 x 256 滤波器大小: 3 x 3 x 256 滤波器个数:384

输出: 13 x 13 x 384

C4层是个卷积层,其输入输出结构如下:

输入: 13 x 13 x 384 滤波器大小: 3 x 3 x 384 滤波器个数:384

输出: 13 x 13 x 384

C5层是个卷积层,其输入输出结构如下:

输入: 13 x 13 x 384 滤波器大小: 3 x 3 x 384 滤波器个数:256

输出: 13 x 13 x 256

P5层是C5后面的池化层,其输入输出结构如下:

输入: 13 x 13 x 256 滤波器大小: 3 x 3 滤波器个数:256

输出: 6 x 6 x 256

F6层是个全连接层,其输入输出结构如下:

输入:6 x 6 x 256

输出:4096

F7层是个全连接层,其输入输出结构如下:

输入:4096

输出:4096

F8层也是个全连接层,即输出层,其输入输出结构如下:

输入:4096

输出:1000

二、代码

# 导包 import keras from keras.models import Sequential from keras.layers import Dense,Activation,Dropout,Flatten,Conv2D,MaxPool2D from keras.layers.normalization import BatchNormalization import numpy as np import tflearn.datasets.oxflower17 as oxflower17 np.random.seed(1000) # 获取数据 x,y = oxflower17.load_data(one_hot=True) # 定义AlexNet模型 model = Sequential() # 1block model.add(Conv2D(filters=97,kernel_size=(11,11),strides=(4,4),padding="valid",input_shape=(224,224,3))) model.add(Activation("relu")) model.add(MaxPool2D(pool_size=(2,2),strides=(2,2),padding="valid")) model.add(BatchNormalization()) # 2block model.add(Conv2D(filters=256,kernel_size=(11,11),strides=(1,1),padding="valid")) model.add(Activation("relu")) model.add(MaxPool2D(pool_size=(2,2),strides=(2,2),padding="valid")) model.add(BatchNormalization()) # 3 block model.add(Conv2D(filters=384,kernel_size=(3,3),strides=(1,1),padding="valid")) model.add(Activation("relu")) model.add(BatchNormalization()) # 4 block model.add(Conv2D(filters=384,kernel_size=(3,3),strides=(1,1),padding="valid")) model.add(Activation("relu")) model.add(BatchNormalization()) # 5 block model.add(Conv2D(filters=256,kernel_size=(3,3),strides=(1,1),padding="valid")) model.add(Activation("relu")) model.add(MaxPool2D(pool_size=(2,2),strides=(2,2),padding="valid")) model.add(BatchNormalization()) # 6 dense model.add(Flatten()) model.add(Dense(4096, input_shape=(224*224*3,))) model.add(Activation("relu")) model.add(Dropout(0.4)) model.add(BatchNormalization()) # 7 dense model.add(Dense(4096)) model.add(Activation("relu")) model.add(Dropout(0.4)) model.add(BatchNormalization()) # 8 dense model.add(Dense(17)) model.add(Activation("softmax")) model.summary() # compile model.compile(loss="categorical_crossentropy",optimizer="adam",metrics=["accuracy"]) # train model.fit(x,y,batch_size=32,epochs=8,verbose=1,validation_split=0.3,shuffle=True)

1234567891011121314151617181920212223242526272829303132333435363738394041424344454647484950515253545556三、结果

1.模型结构

相关知识

Pytorch之AlexNet花朵分类

基于卷积神经网络的花卉识别方法

卷积神经网络实现鸢尾花数据分类python代码实现

深度学习实战:AlexNet实现花图像分类

基于卷积神经网络的花卉识别技术 Flower Recognition Based on Convolutional Neural Networks

深度学习之基于Tensorflow卷积神经网络花卉识别系统

卷积神经网络训练花卉识别分类器

CNN卷积神经网络:花卉分类

卷积神经网络的算法范文

基于卷积神经网络的多尺度葡萄图像识别方法

网址: 【经典卷积神经网络】之AlexNet分析及实现牛津花卉数据集分类 https://m.huajiangbk.com/newsview516088.html

| 上一篇: ResNet |

下一篇: AlexNet实现花卉识别 |