Mistral

最近,NVIDIA 和 Mistral AI 推出了 Mistral NeMo 12B ,这是一款先进的大语言模型 (LLM)。Mistral NeMo 12B 在 各种基准测试 中的表现始终优于类似大小的模型。

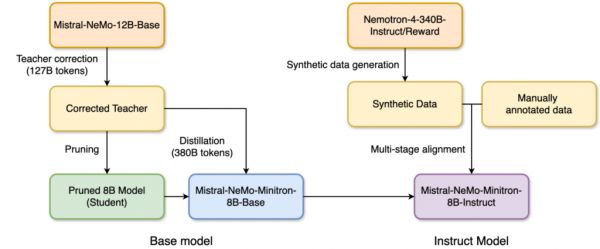

我们宣布推出 Mistral-NeMo-Minitron 8B,这是同类产品中最先进的开放访问模型之一。该模型在九项热门基准测试中始终提供领先的准确性。Mistral-NeMo-Minitron 8B 基础模型是通过对 Mistral NeMo 12B 基础模型 进行宽度剪枝获得的,然后是使用知识蒸馏进行的轻量化重新训练过程。这是 NVIDIA 最初在论文《 通过剪枝和知识蒸馏实现紧凑语言模型 》中提出的成功方法。NVIDIA Minitron 8B 和 4B 以及 Llama-3.1-Minitron 4B 模型不断证明了这一点。

图 1. Model pruning and distillation for Mistral-NeMo-Minitron-8B-Base 和 -Instruct 模型

图 1. Model pruning and distillation for Mistral-NeMo-Minitron-8B-Base 和 -Instruct 模型 在图 1 中,我们使用 Nemotron-4-340B-Instruct 和 Nemotron-4-340B-Reward 模型为比对生成合成数据。

MMLU 5-shot GMS8k 0-shot GPQA 0-shot HumanEval 0-shot MBPP 0-shot IFEval MTBench (GPT4-Turbo) BFCL v2 Live Mistral-NeMo-Minitron 8B Instruct 70.4% 87.1 31.5% 71.3% 72.5% 84.4% 7.86 67.6 Llama-3.1-8B-Instruct 69.4% 83.9% 30.4 72.6% 72.8 79.7 7.78 44.3% Mistral-NeMo-12B-Instruct 68.4% 79.8 28.6% 68.3% 66.7 64.7 8.10 47.9 表 1. Mistral-NeMo-Minitron-8B-Instruct 模型与 Llama-3.1-8B-Instruct 和教师模型 Mistral-NeMo-12B 相比的准确性。粗体数字代表 8B 模型类别中的最佳数字。 训练令牌 Wino-Grande 5-shot ARCChallenge 25-shot MMLU 5-shot Hella

Swag 10-shot GSM8K 5-shot TruthfulQA 0-shot XLSum en (20%)

3-shot MBPP

0-shot Human

Eval

0-shot Llama-3.1-8B 15T 77.27% 57.94 65.28 81.80 48.60 45.06 30.05 42.27 24.76 Gemma-7B 6T 78 61 64 82 50 45 17 39 32 Mistral-NeMo-Minitron-8B 380B 80.35 64.42 69.51% 83.03 58.45 47.56% 31.94 43.77 36.22 Mistral-NeMo-12B 不适用 82.24 65.10 68.99% 85.16 56.41 49.79 33.43 42.63 23.78 表 2. Mistral-NeMo-Minitron-8B-Base 模型与 Llama-3.1-8B-Base 和教师模型 Mistral-NeMo-12B 相比的准确性。粗体数字代表 8B 模型类别中的最佳数字。

模型剪枝和蒸概述

模型剪枝 是缩小模型并使其更精简的过程,方法是减少图层( 深度剪枝 )或减少神经元、注意力头和嵌入通道( 宽度剪枝 )。剪枝通常伴随一些重新训练,以恢复准确性。

模型蒸 是一种技术,用于将知识从复杂的大型模型 (通常称为 教师模型 ) 转移到更小、更简单的 学生模型 。其目标是创建更高效的模型,该模型保留了原始大型模型的大部分预测能力,同时运行速度更快,资源密集度更低。在本文中,我们将蒸作为剪枝后的轻量化重新训练过程,其数据集比从头开始训练模型时使用的数据集要小得多。

迭代剪枝和蒸 是一种从单个预训练模型开始,可以获得多个逐渐较小的模型的方法。例如,可以对 15B 模型进行剪枝和蒸以获得 8B 模型,而这反过来又可以作为剪枝和蒸 4B 模型的起点,以此类推。

模型剪枝与通过蒸馏进行轻度重新训练相结合,是一种高效且经济的方法,用于训练模型系列。对于每个额外的模型,只需使用 100-400B 个令牌即可进行重新训练,与从零开始训练相比,减少了 40 倍以上。因此,与从零开始训练所有模型(12B、8B 和 4B)相比,训练模型系列可节省高达 1.95 倍的计算成本。

从广泛的削减研究中学习已总结为 结构化权重剪枝与知识蒸馏相结合 的 10 种最佳实践。我们发现宽度剪枝始终优于深度剪枝,最重要的是,剪枝和蒸馏后的模型在质量方面优于从头开始训练的模型。

Mistral-NeMo-Minitron 8B

按照最佳实践,我们对 Mistral NeMo 12B 模型进行了宽度精简,以获得 8B 目标模型。本节详细介绍了用于获得 Mistral-NeMo-Minitron 8B 基础模型的步骤和参数,以及其性能。

教师微调

为了纠正训练模型所用的原始数据集上的分布偏移,我们首先使用 127B 个令牌在数据集上微调了未剪枝的 Mistral NeMo 12B 模型。实验表明,在不纠正分布偏移的情况下,教师在提炼数据集时提供了次优指导。

仅宽度的剪枝

鉴于我们的目标是尽可能获得最强的 8B 模型,我们继续进行仅宽度的剪枝。我们沿着宽度轴剪枝了嵌入(hidden)和 MLP 中间维度,以压缩 Mistral NeMo 12B。具体来说,我们使用基于激活的策略计算了每个注意力头、嵌入通道和 MLP 隐藏维度的重要性分数。在重要性估计之后,我们:

将 MLP 中间维度从 14336 剪枝至 11520 将隐藏大小从 5120 剪枝为 4096 保留了注意力头数和层数。蒸参数

我们利用峰值学习率 = 1e-4,最低学习率 = 4.5e-7,60 个步骤的线性热身,余弦衰减时间表,以及使用 380B 令牌(与教师微调中使用的数据集相同)的全局批量大小 768,对模型进行了提炼。

Mistral-NeMo-Minitron-8B-Instruct

我们应用了由两阶段指令微调和两阶段偏好优化组成的高级比对技术,从而打造出在指令跟随、语言推理、函数调用和安全基准测试方面表现优异的先进指令模型。

对齐数据是使用 Nemotron-340B-Instruct 模型和 Nemotron-340B-Reward 模型合成生成的。模型对齐是使用 NVIDIA NeMo Aligner 完成的。

性能基准测试

我们使用 NVIDIA TensorRT-LLM (用于优化 LLM 推理的开源工具包) 优化了 Mistral-NeMo-Minitron-8B-Base 模型、教师 Mistral-NeMo-12B 模型和 LLama-3.1-8B 模型。

图 2 和 3 显示了不同模型在 FP8 和 BF16 精度下,在不同用例中每秒吞吐量的请求,以批量大小为 32 时的输入序列长度/输出序列长度(ISL/OSL)组合表示,在一个 NVIDIA H100 80-GB GPU 上。

Llama-3.1-8B 模型速度最快,Mistral-NeMo-12B 的平均吞吐量约为 1.4 倍,其次是 Mistral-NeMo-Minitron-8B-Base,比 Mistral-NeMo-12B 改进了 1.2 倍。这主要是因为 Llama-3.1-8B 模型有 32 层,而 Mistral-NeMo-12B 有 40 层。

与 BF16 相比,FP8 中的部署还可将所有三个模型的性能提升约 1.4 倍。

图 2. 不同 I/O 长度组合下请求 BF16 吞吐量的性能基准

图 2. 不同 I/O 长度组合下请求 BF16 吞吐量的性能基准  图 3. 不同 I/O 长度组合下请求 FP8 吞吐量的性能基准测试

图 3. 不同 I/O 长度组合下请求 FP8 吞吐量的性能基准测试 结束语

Mistral-NeMo-Minitron-8B 提供业界领先的准确性,并且始终优于最近推出的类似大小的最先进模型。Mistral-NeMo-Minitron-8B 是我们对 Mistral-NeMo-12B 模型进行蒸馏的首个工作,为 我们的结构化权重剪枝与知识蒸馏 最佳实践提供了强有力的支持。

Mistral-NeMo-Minitron-8B-Instruct 还展示了我们的最先进的比对训练方法。我们计划进一步进行 蒸馏 、比对并获得更小、更准确的模型。 NVIDIA NeMo 框架为生成式 AI 训练提供了 深度剪枝 和蒸馏的支持。示例用法以 Notebook 的形式提供。

有关更多信息,请参阅以下资源:有关更多信息,请参阅以下资源:

LLM 剪枝和蒸馏在实践中的应用:Minitron 方法 通过剪枝和知识蒸馏构建紧凑语言模型 /NVlabs/Minitron GitHub 库 /NVIDIA/NeMo-Aligner GitHub 库 Mistral-NeMo-Minitron-8B-Base 模型 on Hugging Face Mistral-NeMo-Minitron 8B-Instruct 模型 在 Hugging Face Mistral-NeMo-Minitron-8B-Instruct 模型 在 NVIDIA API 目录中致谢

这项工作如果没有 NVIDIA 许多人的贡献是不可能实现的。 仅举其中几个例子:

基础模型 :Sharath Turuvekere Sreenivas, Saurav Muralidharan, Raviraj Joshi, Marcin Chochowski, Sanjeev Satheesh, Jupinder Parmar, Pavlo Molchanov, Mostofa Patwary, Daniel Korzekwa, Ashwath Aithal, Mohammad Shoeybi, Bryan Catanzaro, 和 Jan Kautz

对齐 :Gerald Shen、Jiaqi Zeng、Ameya Sunil Mahabaleshwarkar、Zijia Chen、Hayley Ross、Brandon Rowlett、Oluwatobi Olabiyi、Shizhe Diao、Yoshi Suhara、Shengyang Sun、Zhilin Wang、Yi Dong、Zihan Liu、Rajarshi Roy、Wei Ping、Makesh Narsimhan Sreedhar、Shaona Ghosh、Somshubra Majumdar、Vahid Noroozi、Aleksander Ficek、Siddhartha Jain、Wasi Uddin Ahmad、Jocelyn Huang、Sean Narenthiran、Igor Gitman、Shubham Toshniwal、Ivan Moshkov、Evelina Bakhturina、Matvei Novikov、Fei Jia、Boris Ginsburg 和 Oleksii Kuchaiev

TensorRT-LLM :Bobby Chen, James Shen 和 Chenhan Yu。

Hugging Face 支持 :Ao Tang、Yoshi Suhara 和 Greg Heinrich。

相关知识

开学10天一切正常!京东鲜花教师节千株蝴蝶兰致敬武汉中小学教师

DeepSeek这么便宜竟然还有50%利润率?字节AIGC产品大爆发了;AI解梦靠谱吗?AI MV制作手册

论文阅读:The Unreasonable Ineffectiveness of the Deeper Layers 层剪枝与模型嫁接的“双生花”

网址: Mistral https://m.huajiangbk.com/newsview502066.html

| 上一篇: 鉴证科丨音乐剧《芝加哥》:黑红美 |

下一篇: 常州市市场监管局关于发布市地方标 |