机器学习算法其一:鸢尾花数据集逻辑回归分类预测学习总结

参考学习原文章:工作台 - Heywhale.com

本文仅作学习总结,如有帮助也可参考。

鸢尾花数据集逻辑回归分类预测

一、逻辑回归

一、逻辑回归介绍逻辑回归(Logistic Regression)是一种广泛使用的统计方法,用于预测二分类(binary)或多分类(multinomial)问题的结果。尽管其名称中包含“回归”,实际上逻辑回归是一种分类算法,主要用于预测一个观测值属于特定类别的概率。

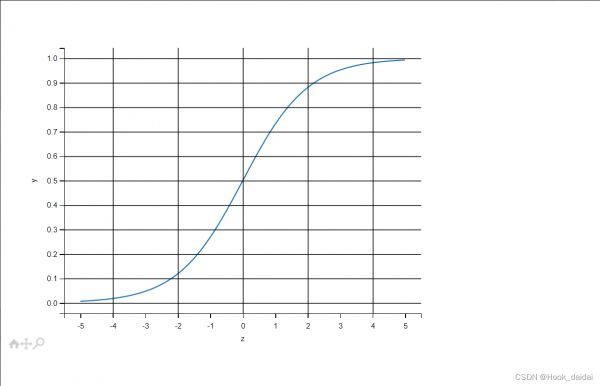

二、逻辑回归原理逻辑回归通过应用一个逻辑函数(通常是Sigmoid函数)将线性回归的输出映射到0和1之间,这个输出被解释为属于某个类别的概率。Sigmoid函数的公式是:

logi(z)=11+e−z" role="presentation">logi(z)=11+e−z

其中,z是特征与其权重的线性组合,即:z=β0+β1x1+β2x2+...+βnxn

β0是截距项,β1,β2,...,βn是模型参数,x1,x2,...,xn是特征。 三、训练逻辑回归模型的训练涉及到找出能最好地拟合给定数据集的模型参数(β值)。这通常通过最大化对数似然函数来实现,这个过程被称为最大似然估计(MLE)。

四、预测模型训练完成后,可以通过多种方式评估其性能,包括准确率、召回率、精确率和F1分数等。此外,接收者操作特征(ROC)曲线及其下面积(AUC)也是评估二分类问题性能的常用指标。

五、优缺点突出优点:其模型简单和模型的可解释性强。

优点 简单且高效:逻辑回归模型简单易于实现,对于小到中等大小的数据集来说非常高效。解释性强:模型的结果易于解释,可以清楚地了解特征如何影响预测结果。概率输出:逻辑回归提供了观测值属于某个类别的概率估计,这比简单的二元输出更为丰富。 缺点 线性边界:逻辑回归假设数据有线性边界,对于复杂的非线性关系可能不够灵敏。高度依赖数据表示:逻辑回归的性能在很大程度上依赖于输入数据的正确表示(如特征选择和处理)。对异常值敏感:异常值或极端值可能对模型的性能产生不利影响。 六、图像import numpy as np

import matplotlib.pyplot as plt

x = np.arange(-5,5,0.01)

y = 1/(1+np.exp(-x))

plt.plot(x,y)

plt.xlabel('z')

plt.ylabel('y')

plt.grid()

plt.show()

二、对鸢尾花数据集进行分类预测

一、鸢尾花数据集介绍该数据集一共包含5个变量,其中4个特征变量,1个目标分类变量。共有150个样本,目标变量为 花的类别 其都属于鸢尾属下的三个亚属,分别是山鸢尾 (Iris-setosa),变色鸢尾(Iris-versicolor)和维吉尼亚鸢尾(Iris-virginica)。包含的三种鸢尾花的四个特征,分别是花萼长度(cm)、花萼宽度(cm)、花瓣长度(cm)、花瓣宽度(cm)。

变量描述sepal length 花萼长度(cm)sepal width花萼宽度(cm)petal length花瓣长度(cm)petal width花瓣宽度(cm)target鸢尾的三个亚属类别,'setosa'(0), 'versicolor'(1), 'virginica'(2) 二、数据集处理 一、导入库函数import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

在进行数据处理时需要调用numpy 和 pandas 库,以及在后续数据可视化的时候需要调用matplotlib来进行画二维,三维图。

二、数据读取及查看from sklearn.datasets import load_iris

data = load_iris()

iris_target = data.target

iris_features = pd.DataFrame(data=data.data, columns=data.feature_names)

特征统计:iris_features.describe()

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

iris_features_part = iris_features.iloc[:100]

iris_target_part = iris_target[:100]

x_train, x_test, y_train, y_test = train_test_split(iris_features_part, iris_target_part, test_size = 0.2, random_state = 2020)

clf = LogisticRegression(random_state=0, solver='lbfgs')

clf.fit(x_train, y_train)

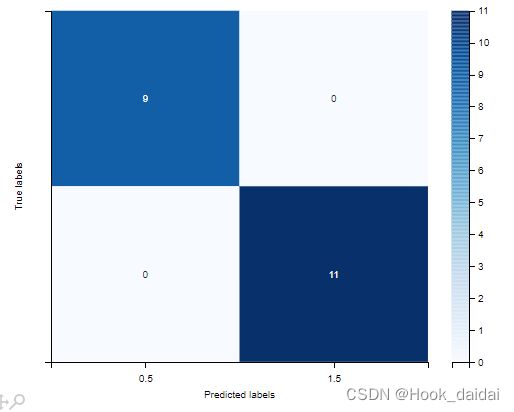

仅选取标签为0 和 1 的样本进行二分类训练训练集测试集4:1进行训练 二、预测from sklearn import metrics

train_predict = clf.predict(x_train)

test_predict = clf.predict(x_test)

print('The accuracy of the Logistic Regression is:',metrics.accuracy_score(y_train,train_predict))

print('The accuracy of the Logistic Regression is:',metrics.accuracy_score(y_test,test_predict))

confusion_matrix_result = metrics.confusion_matrix(test_predict,y_test)

print('The confusion matrix result:n',confusion_matrix_result)

plt.figure(figsize=(8, 6))

sns.heatmap(confusion_matrix_result, annot=True, cmap='Blues')

plt.xlabel('Predicted labels')

plt.ylabel('True labels')

plt.show()

利用训练好的模型直接进行预测再通过accuracy进行一个预测评估利用混淆矩阵来预测真实值与预测值的差别

三、总结

通过机器学习中逻辑回归对鸢尾花数据的处理以及预测,简单的进行二分类的实现。

sklearn 自带的iris数据进行数据载入describe()是Pandas库中的一个函数,用于生成关于数据框的基本统计摘要的信息。这些统计信息包括计数、均值、标准差、最小值、25th、50th(中位数)、75th百分位数以及最大值。对于模型的训练而言:实质上来说就是利用数据求解出对应的模型的特定的w。从而得到一个针对于当前数据的特征逻辑回归模型。 而对于多分类而言,将多个二分类的逻辑回归组合,即可实现多分类。相关知识

《机器学习》分析鸢尾花数据集

python鸢尾花数据集的分类问题 -- 逻辑回归问题研究

【机器学习】KNN算法实现鸢尾花分类

【机器学习】鸢尾花分类:机器学习领域经典入门项目实战

机器学习之路:经典的鸢尾花数据集

机器学习算法

【机器学习】鸢尾花分类

【python机器学习】KNN算法实现回归(基于鸢尾花数据集)

分析鸢尾花数据集

基于Logistic回归模型对鸢尾花数据集的线性多分类

网址: 机器学习算法其一:鸢尾花数据集逻辑回归分类预测学习总结 https://m.huajiangbk.com/newsview547965.html

| 上一篇: 精准农业的智能化:大模型在作物监 |

下一篇: 西兰花叶干燥模型的建立和验证 |