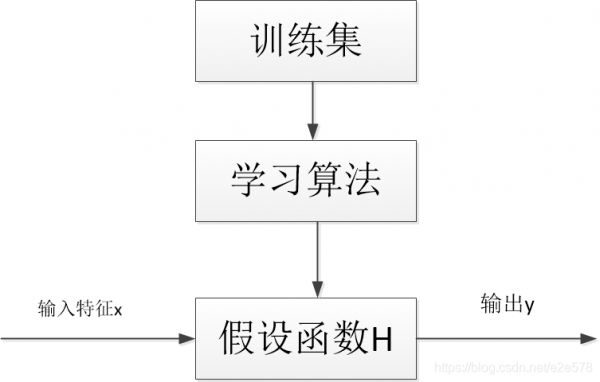

m:训练集的数样本目,x:输入特征,y:输出变量,(x,y):一个训练样本,(x(i),y(i)):第i个训练样本,上标i不是指幂函数,而是索引,即表格中第i行。h:假设函数,接收输入的训练集,

线性回归模型

一元线性回归模型公式:

h θ ( x ) = θ 0 + θ 1 x h_theta(x)=theta_0+theta_1x hθ(x)=θ0+θ1x

2. 代价函数(1)

θ 0 , θ 1 theta_0,theta_1 θ0,θ1:模型参数。如何选择不同的模型参数,使得假设函数表示的直线,尽量与数据点较好地拟合?

(在线性回归中,我们要解决的是一个最小化问题,见下式,我们需要减少预测价格和实际价格的平均误差。)

1 2 m ( ∑ i = 1 m h θ ( x ) − y ) 2 frac{1}{2m}(sum_ {i=1}^{m}{h_theta(x)-y)^2} 2m1(i=1∑mhθ(x)−y)2

注: 1 2 frac{1}{2} 21只是用于求导计算方便将 h θ ( x ) h_theta(x) hθ(x)的表达式代入上式得 1 2 m ( ∑ i = 1 m ( θ 0 + θ 1 x − y ) 2 frac{1}{2m}(sum_ {i=1}^{m}{(theta_0+theta_1x-y)^2} 2m1(i=1∑m(θ0+θ1x−y)2故我们只需要关心 θ 0 , θ 1 theta_0,theta_1 θ0,θ1的变化。我们想要做的就是关于 θ 0 和 θ 1 theta_0和theta_1 θ0和θ1,对函数 J ( θ 0 , θ 1 ) J(theta_0,theta_1) J(θ0,θ1)求最小值,代价函数(Cost Function)见下式,此代价函数是解决回归问题最常用的手段。

J ( θ 0 , θ 1 ) = 1 2 m ( ∑ i = 1 m h θ ( x ) − y ) 2 J(theta_0,theta_1)=frac{1}{2m}(sum_ {i=1}^{m}{h_theta(x)-y)^2} J(θ0,θ1)=2m1(i=1∑mhθ(x)−y)2

3. 代价函数(2)

为了更好地使代价函数J可视化,我要使用一个简化的假设函数,见下式,即 θ 0 = 0 theta_0=0 θ0=0。

h θ ( x ) = θ 1 x h_theta(x)=theta_1x hθ(x)=θ1x

故新的代价函数为: J ( θ 1 ) = 1 2 m ( ∑ i = 1 m ( θ 1 x i − y i ) 2 J(theta_1)=frac{1}{2m}(sum_ {i=1}^{m}{(theta_1x^i-y^i)^2} J(θ1)=2m1(i=1∑m(θ1xi−yi)2

我们的优化目标是尽量减小 J ( θ 1 ) J(theta_1) J(θ1)。